Crawling und Indexierung von Webseiten: Theorie und Praxis

Durch Crawling und die Indexierung werden Webseiten im Index der Suchmaschine aufgenommen und haben so die Möglichkeit, auf den Suchergebnissseiten (SERPs) zu ranken. Bei der Erstellung und Optimierung von Webseiten muss demnach, sofern die Seiten in den organischen Suchergebnissen erscheinen sollen, darauf geachtet werden, dass diese gut gecrawlt werden können. So stellst Du sicher, dass alle relevanten Inhalte der Webseite im Index der Suchmaschinen landen. Grundsätzlich kann ein Webcrawler nur Inhalte indexieren, die er auch finden kann. Deswegen sollte eine Seite immer eine möglichst flache Hierarchie und eine durchdachte interne Verlinkung aufweisen. Setze Dich intensiv mit dem Thema Crawling und Indexierung auseinander, um die Suchmaschinen bestmöglich mit relevanten Inhalten zu füttern. Mit diesem Blogartikel helfen wir Dir dabei.

Inhalt

- Was bedeutet Crawling?

- Was bedeutet Indexierung?

- Was versteht man unter Crawl-Budget & Index-Budget?

- Wie wichtig sind Crawling & die Indexierung in der Suchmaschinenoptimierung?

- Wie kann ich das Crawling & die Indexierung meiner Webseite steuern?

- Praktisches Beispiel: Duplicate Content durch Parameter-URLs vermeiden

- Fazit

Was bedeutet Crawling?

Als Crawling wird die Identifizierung von öffentlich zugänglichen Webseiten durch spezielle Software verstanden. Der bekannteste Crawler ist der Googlebot, der für die Suchmaschine Google das Internet nach allen verfügbaren Seiten durchsucht. Dazu ruft ein Crawler Webseiten auf und folgt allen internen und externen Verlinkungen, um möglichst viele Seiten zu indexieren.

„Fängt ja schon damit an beim Crawling, das ist praktisch das Eintrittstor in den Google Index.“

Rene Dhemant

Kostenloses E-Book: 10 goldene SEO-Regeln

Schluss mit den Mythen: Mit diesen 10 Regeln bist Du auf dem sicheren Weg, wenn es um Suchmaschinenoptimierung geht. Jetzt downloaden!

Was bedeutet Indexierung?

Die durch das Crawling erfassten Daten werden von Suchmaschinenbetreiber:innen indexiert und damit den Suchmaschinen zur Verfügung gestellt. Der Index ist hierbei die Speicherung aller gecrawlten Seiten, die nicht von den Webseitenbetreiber:innen ausgeschlossen wurden bzw. von den Suchmaschinen als irrelevant betrachtet wurden. Der Index bildet die Datengrundlage, auf die bei einer Suchanfrage durch eine:n Nutzer:in zurückgegriffen wird. Diese Suchanfrage setzt dann einen komplexen Algorithmus in Gang, um die bestmöglichen Ergebnisse ausliefern zu können.

Google verarbeitet rund 40.000 Suchanfragen pro Sekunde und erhält täglich rund 3,5 Milliarden Suchanfragen

Internetlivestats, 2023

Wie finde ich heraus, ob meine Seite indexiert ist?

Wird auf der Webseite eine neue Unterseite angelegt, so ist das Bestreben in den meisten Fällen, dass diese von Nutzern und Nutzerinnen über die Suchmaschinen gefunden wird. Wie wir nun bereits wissen, muss die Seite dafür gecrawlt und indexiert werden. Ob dies geglückt ist, lässt sich durch die Site-Abfrage oder die Google Search Console einfach herausfinden.

Site-Abfrage

Im Suchfeld der Suchmaschinen hast Du durch die Eingabe sogenannter Suchoperatoren die Möglichkeit, die Suchergebnisse zu filtern. Diese werden direkt im Suchfeld zusammen mit Deiner Suchanfrage eingegeben. “Site” ist ein solcher Suchoperator, der Dir hilft, die Indexierung deiner Webseiter oder spezifischer URLs zu untersuchen. Gebe hierfür einfach “site:www.domain.com” in das Suchfeld ein, um Dir alle indexierten Seiten ausgeben zu lassen oder teste mit “site:https://www.domain.com/unterseite” eine spezifische Unterseite. Erscheint die Seite in den Suchergebnissen, so wurde sie gecrawlt und indexiert.

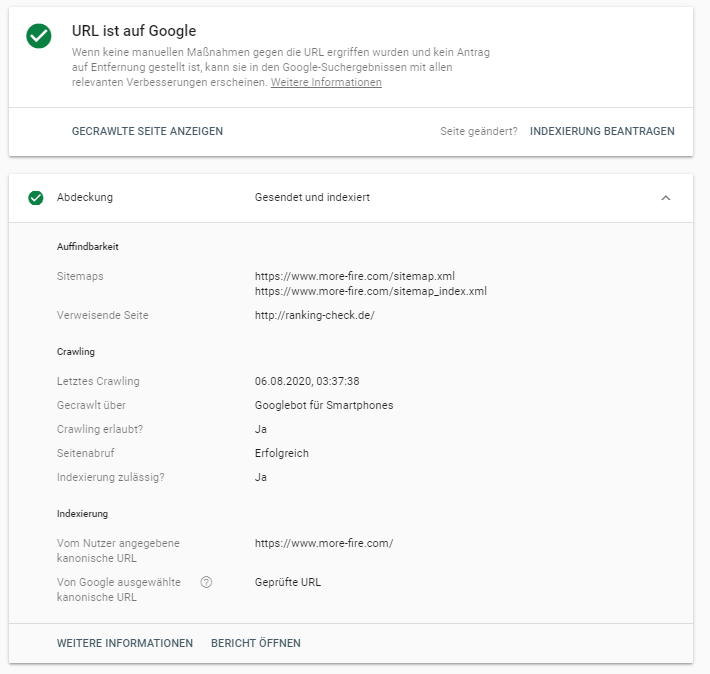

Search Console URL-Prüfung

Wie es Google bereits in der Site-Abfrage vorschlägt, kann die Indexierung auch über die Search Console überprüft werden. Voraussetzung ist hier jedoch, dass Du Zugriff zu der Website-Property hast. Im Suchfeld der Google Search Console kannst du dann einzelne URLs prüfen. Im Abdeckungsbericht findest Du sämtliche Informationen zum Crawling und der Indexierung der Seite:

Können Seiten aus dem Index fliegen?

Wurde eine URL in den Index der Suchmaschine aufgenommen, so stellt dies keine Garantie dar, dass sie dort auch bleibt. Verschiedene Faktoren können dazu führen, dass Seiten wieder aus dem Index entfernt werden:

- Passwortgeschützt: Wurde der Zugang zur Seite durch ein Passwort geblockt, so kann diese Seite nicht mehr gecrawlt werden. Eine Seite, die weder für den Crawler, noch für NutzerInnen zugänglich ist, wird aus dem Index entfernt.

- Statuscodes 4xx & 5xx: Ist eine Seite durch einen Fehler (Client-Fehler 4xx oder Server-Error 5xx) nicht mehr auffindbar bzw. aufrufbar, so wird diese auf kurz oder lang aus dem Index entfernt. Handelt es sich hierbei um wichtige Seiten, sollten diese bestmöglich durch den Statuscode 301 weitergeleitet werden, um Rankingsverluste zu vermeiden.

- Noindex: Hat der Webseitenbetreiber auf der Seite das Meta Robots Tag “noindex” im Quellcode hinterlegt, weist er hiermit die Suchmaschine darauf hin, dass diese Seite aus dem Index entfernt werden soll. Ist dieser Text von Anfang an hinterlegt, wird die Seite gar nicht erst in den Index aufgenommen.

- Verstoß gegen Webmaster Guidelines: Zu guter Letzt ahndet z.B. Google Verstöße einer Seite gegen ihre Webmaster Guidelines mit einem Ausschluss dieser aus dem Index.

Was versteht man unter Crawl-Budget & Index-Budget?

Für Internetauftritte mit wenigen Seiten und/oder Webseiten deren URLs ohnehin in der Regel am ersten Tag indexiert werden, ist das Thema Crawling-Budget weniger wichtig. Für große Seiten mit mehreren Tausend oder Millionen URLs, ist es wichtig das Crawling-Budget zu optimieren. Doch was kannst Du dir unter einem Crawling-Budget vorstellen und was ist eigentlich die Crawling-Frequenz und der Crawling-Bedarf?

Vereinfacht gesagt handelt es sich beim Crawling-Budget um die Anzahl der URLs die der Bot auf einer Seite crawlen kann und crawlen will. Dieses Budget setzt sich aus der Crawling-Frequenz (Können) und dem Crawling-Bedarf (Wollen) zusammen.

Die Crawling-Frequenz steht für die Anzahl der Anfragen pro Sekunde, die der Bott während des Crawlings auf einer Seite ausführt. Hierbei gilt: Je schneller die Ladezeit ist und je weniger Serverfehler vorhanden sind, desto höher ist die Frequenz. Eine technische Optimierung der Seite wirkt sich somit als klar positiv auf die Crawling-Frequenz aus.

Suchmaschinenbots crawlen bevorzugt Seiten, die beliebt sind. Die Beliebtheit wird hier durch eine Reihe von Faktoren wie Verlinkung, Aufenthaltsdauer und Absprungrate bestimmt. Seiten, die als weniger beliebt sind und/oder als veraltet eingestuft werden, werden seltener oder gar nicht gecrawlt. Der Crawling-Bedarf ist also ein Wert der einschätzt, wie wichtig es für einzelne Seiten ist, regelmäßig gecrawlt zu werden oder eben nicht. Seiten mit geringem Mehrwert wirken sich negativ auf Crawling und Indexierung aus, wodurch gute Inhalte erst später gefunden werden. Geringer Mehrwert bedeutet im Einzelnen: Duplicate Content, Soft-404-Fehler, Spam und Seiten ohne Mehrwert. Es ist also eine komplexe Optimierung von verschiedenen Faktoren erforderlich um an beiden Stellschrauben zu drehen.

Die #1 in den organischen Google Suchergebnissen hat eine CTR von 31,7% und hat eine 10 mal höhere Wahrscheinlichkeit geklickt zu werden als das Ergebnis auf Platz 10 derselben Seite

Backlinko, 2023

Und Vorsicht! Auch Crawl-Budget ist irgendwann aufgebraucht. Es kann durch Relaunches, Änderung der URL-Struktur oder Weiterleitungsketten belastet werden. Dies führt nämlich dazu, dass URLs einer Webseite immer wieder neu gecrawlt werden müssen. Ist das Crawl-Budget aufgebraucht, kann dies dazu führen, dass wichtige Seiten nicht gecrawlt und dadurch nicht im Index der Suchmaschine aufgenommen werden, ergo auch von Nutzern und Nutzerinnen nicht gefunden werden.

Das Crawl-Budget wird von dem Index-Budget unterschieden. Letzteres bezieht sich auf die Anzahl der Seiten einer einzigen Domain, die im Index der Suchmaschinen aufgenommen werden. Auch diese Anzahl ist limitiert und nur die URLs, die regelmäßig gecrawlt werden, haben die Möglichkeit, auch im Index zu bleiben.

Du willst noch tiefer in die Thematik eintauchen? Rene Dhemant gibt in unserem morefire Kneipentalk Einblick in die Themen Crawl-Budget und Indexing.

Wie wichtig sind Crawling & die Indexierung in der Suchmaschinenoptimierung?

Die Suchmaschinenoptimierung hat das Ziel, eine Seite so zu optimieren, dass sie für bestimmte Keywords bestenfalls auf Position 1 der Suchergebnissseite landet. Grundbaustein solcher Optimierungen ist, dass die Seite gecrawlt und indexiert werden kann.

Als SEO musst Du demnach immer auch die Crawlbarkeit der Webseite beachten und mögliche Schwachstellen identifizieren können, um eine Indexierung der Seite nicht zu gefährden. Für SEOs ist es vor allem wichtig, den Crawler so zu steuern, dass alle relevanten Seiten gefunden und indexiert werden können. Sind Seiten weniger relevant oder verursachen Duplicate Content, so kann der Webcrawler über verschiedene Wege darauf hingewiesen werden.

Du willst mehr zum Thema SEO erfahren? Dann findest du hier unseren SEO-Ratgeber!

Wie kann ich das Crawling & die Indexierung meiner Webseite steuern?

Neben passiven Einflüssen wie der Seitenperformance (Ladegeschwindigkeit, Serverfehler etc.), hat ein Webmaster die Möglichkeit, das Crawling aktiv zu beeinflussen. Dies geht auf sehr verschiedene Arten und Weisen. Die Steuerung von Crawling und Indexierung ist beispielsweise Teil einer SEO-Beratung.

Crawling-Steuerung durch die Robots.txt

Mithilfe einer robots.txt, die immer im Root-Verzeichnis einer Domain (www.beispiel.de/robots.txt) liegen muss, kann man Crawlern verschiedene Anweisungen geben:

- Einzelne Crawler von der ganzen Seite oder einzelnen Verzeichnissen ausschließen

- Einen Verweis auf die Adresse einer oder mehrerer XML-Sitemaps geben

Die Befehle einer robots.txt sind nur eine Empfehlung und werden nicht zwingend von Suchmaschinen berücksichtigt. Ausführliche Informationen zu den Möglichkeiten einer robots.txt findet Ihr unter: robots.txt – Was ist das und wie wende ich diese an?

Indexierung verhindern durch Noindex

Der Meta-tag „noindex“ wird im Bereich einer Seite implementiert und sieht wie folgt aus: . Es wird Crawling-Budget verbraucht, wenn eine solche Seite aufgerufen wird, wird die Seite jedoch nicht indexiert. Die noindex-Anweisung ist verbindlich, das heißt, die Seite wird nach dem nächsten Crawling aus dem Index der Suchmaschinen genommen.

Nützlich sind solche Tags beispielsweise bei folgenden Seiten:

- Paginierte Seiten

- URLs mit Parametern durch z.B. Filterfunktionen

- Suchergebnisseiten

Indexierung steuern durch Canonicals

Anders als die noindex-Anweisung sind Canonicals nicht bindend für Suchmaschinen, das heißt, es gibt keine Garantie, dass Suchmaschinen den Empfehlungen folgen.

Anders als die noindex-Anweisung geht es hier nicht darum, eine Seite aus dem Index zu nehmen, sondern Du sprichst eine Empfehlung aus, welche URL anstelle der gerade aufgerufenen Seite indexiert werden soll.

Dies ist zum Beispiel praktisch bei einem Onlineshop, wenn durch Filterfunktionen, Duplicate von Kategorieseiten entstehen.

Crawling-Steuerung über die Search Console

In der Search Console kann man beispielsweise URL-Parameter ausschließen und die Crawling-Frequenz reduzieren.

URLs mit bestimmten Parametern schließt man unter „Vorherige Tools und Berichte“ – „URL-Parameter“ aus. Dies ist praktisch, um beispielsweise Parameter-URLs, die durch Filtereinstellungen auf der Webseite generiert werden, von der Indexierung auszuschließen. Wichtig ist hierbei zu erwähnen, dass 1. diese Einstellungen nur für Google gilt, nicht jedoch für andere Suchmaschinen. Und 2. sollte das Problem im Idealfall natürlich mithilfe anderer Mittel (robots.txt, noindex, Canonicals) oder der Vermeidung der Generierung von Filter-URLs auf der Webseite behoben werden, sodass die Notlösung über die Google Search Console gar nicht erst notwendig wird.

Unter „Vorherige Tools und Berichte“ – “Weitere Informationen” – “Einstellungen für die Crawling-Frequenz” kann zudem eine maximale Crawling-Frequenz eingestellt werden. Hierbei können Werte von wenigen bis zu vielen Anforderungen pro Sekunde ausgewählt werden. Die Crawling-Frequenz sollte nur beschränkt werden, wenn Google den Server der Seite verlangsamt.

Achtung: Diese Einstellung ist nur 90 Tage gültig und muss dann erneut vorgenommen werden. Auch hier gilt: dies ist nur eine Notlösung! Wenn Crawler den Server der Seite verlangsamen, sollten unbedingt Optimierungen an der Serverleistung vorgenommen werden.

Praktisches Beispiel: Duplicate Content durch Parameter-URLs vermeiden

Es gibt eine Kategorie-Seite

https://www.beispiel-shop.de/kategorie

Und mehrere Filter-URLs, wie z.B. diese:

https://www.beispiel-shop.de/kategorie?filter-farbe

https://www.beispiel-shop.de/kategorie?filter-preis

Dadurch entsteht Duplicate Content, weil alle drei URLs bis auf die angezeigten Produkte identisch sind (Meta Daten, Überschrift, Text etc.). Hier einige Vor- und Nachteile der vier verschiedenen Varianten:

Search Console

Vorteile:

- Funktioniert verbindlich bei Google

Nachteile:

- Relativ komplizierte Konfiguration

- Gilt nur für Google, hat keine Relevanz für andere Suchmaschinen

robots.txt

Vorteile:

- Gültig für alle Suchmaschine

Nachteile:

- Nur eine Empfehlung, ist nicht verbindlich

noindex

Vorteile:

- Verbindliche Methode, um Seiten aus dem Index zu entfernen

- Gültig für alle Suchmaschinen

Nachteile:

- Kein Verweis auf die relevante (kanonische) Seite möglich

Canonical

Vorteile:

- Gültig für alle Suchmaschinen

- Verweis auf relevante Seite, in diesem Fall die Kategorie-Seite

Nachteile:

- Nur eine Empfehlung, wird meistens übernommen, jedoch nicht immer

In diesem Fall würde ich die Filter-URLs auf noindex setzen. Damit ist gewährleistet, dass nur die Kategorie-Seiten im Index erfasst werden und es keinen Duplicate Content gibt.

Hierzu gibt es jedoch zwei Alternativen:

Erstens kannst Du CMS-Systeme so einstellen, dass sich durch die Filterung nicht die URL ändert. Dies ist jedoch nur bei wenigen CMS-Systemen möglich und setzt umfangreiches technisches Know-how voraus.

Zweitens gibt es die Möglichkeit einzelne Filterseiten zu optimieren.

Anstatt eine URL (Beispiel : https://www.beispiel-shop.de/kategorie?filter-farbe) auf noindex zu setzen, kannst Du sie auch mit einem individuellen Title Tag, einer Meta Description, einer H1-Überschrift und einem spezifischen Text versehen. Damit ist die Seite kein Duplikat der eigentlichen Kategorieseite mehr und die Seite kann sogar zusätzlich verlinkt und zur Generierung von Rankings genutzt werden. Auch diese Möglichkeit hängt maßgeblich vom CMS und der verwendeten Technik ab.

Kostenloses Webinar: Deine perfekte SEO-Strategie

Setze Ziele, optimiere Deine Inhalte und finde die Balance zwischen gutem Content, Erfolg & technischen Maßnahmen.

Fazit

Es ist für Webseitenbetreiber sehr wichtig, das Crawling der Sluchmaschinen zu lenken und die Indexierung der einzelnen URLs zu steuern. Es gibt eine Vielzahl von Möglichkeiten, dies zu tun, angefangen mit einer schlanken, flachen Seitenhierarchie bis hin zur Sperrung einzelner Seiten für den Index. Die theoretischen Grundlagen habe ich in diesem Artikel erläutert und an dem Beispiel eine mögliche Umsetzung veranschaulicht. Das Thema ist sehr komplex und je nach Anwendungsfall müssen individuelle Lösungen mit dem Ziel relevante URLs in den Index zu bekommen ausgearbeitet werden und nicht-relevante URLs bzw. Duplikate aus dem Index herausgehalten werden.